En la era digital, la información se ha convertido en el activo más valioso. Las empresas, las instituciones y los individuos generan cantidades masivas de datos a un ritmo sin precedentes. Este fenómeno, conocido como Big Data, presenta tanto oportunidades como desafíos. Para aprovechar al máximo el potencial de Big Data, es esencial comprender y optimizar los flujos de trabajo asociados con la gestión, el análisis y la utilización de estos datos.

Definición de Flujos de Trabajo de Big Data

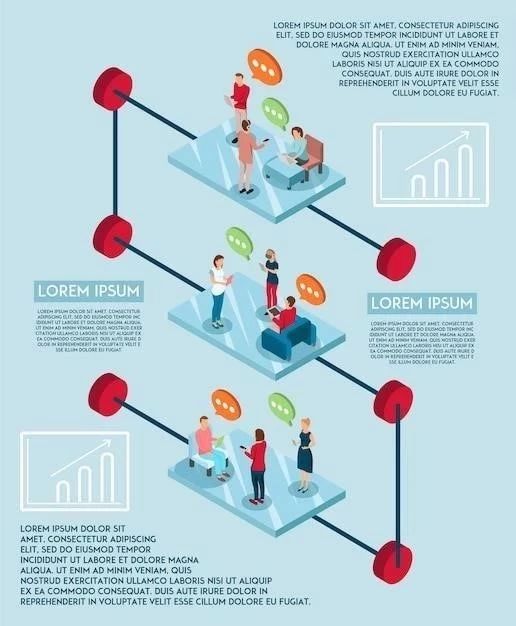

Un flujo de trabajo de Big Data es un proceso estructurado que abarca todas las etapas, desde la adquisición y la preparación de los datos hasta la generación de información útil y la toma de decisiones. Estos flujos de trabajo se caracterizan por su complejidad, involucrando una serie de herramientas, tecnologías y procesos interconectados.

Etapas Clave en un Flujo de Trabajo de Big Data

Un flujo de trabajo de Big Data típico se compone de las siguientes etapas esenciales⁚

1. Adquisición de Datos

El primer paso consiste en capturar los datos de diversas fuentes, como bases de datos, archivos de registro, sensores, redes sociales, dispositivos móviles y más. Esta etapa implica la integración de datos de diferentes formatos y estructuras, lo que puede ser un desafío considerable.

2. Almacenamiento de Datos

Una vez adquiridos, los datos deben almacenarse de forma eficiente y segura. Las tecnologías de almacenamiento de Big Data, como Hadoop y NoSQL, son esenciales para gestionar volúmenes masivos de datos de forma distribuida y escalable.

3. Limpieza y Transformación de Datos

Los datos crudos suelen contener errores, valores faltantes, inconsistencias y duplicados. La limpieza y transformación de datos implica la detección y corrección de estos problemas para garantizar la calidad y confiabilidad de los datos.

4. Procesamiento de Datos

El procesamiento de datos implica la aplicación de algoritmos y técnicas para extraer información significativa de los datos. Las plataformas de procesamiento distribuido, como Hadoop y Spark, son esenciales para manejar la complejidad computacional de los conjuntos de datos de Big Data.

5. Análisis de Datos

El análisis de datos se centra en la exploración, el modelado y la interpretación de los datos para obtener información útil. Se utilizan técnicas de análisis estadístico, minería de datos y aprendizaje automático para identificar patrones, tendencias y relaciones ocultas en los datos.

6. Visualización de Datos

La visualización de datos es esencial para comunicar los hallazgos del análisis de forma clara y concisa. Las herramientas de visualización de datos permiten crear gráficos, mapas, tableros y otros elementos visuales que facilitan la comprensión de los datos.

7. Toma de Decisiones

La información derivada del análisis de datos se utiliza para tomar decisiones informadas en diferentes áreas, como la optimización de procesos, la mejora de productos, la gestión de riesgos, la personalización de la experiencia del cliente y la creación de nuevas oportunidades de negocio.

Tecnologías Clave para Flujos de Trabajo de Big Data

Las siguientes tecnologías son fundamentales para la implementación exitosa de flujos de trabajo de Big Data⁚

1. Plataformas de Almacenamiento de Big Data

- Hadoop⁚ Un sistema de almacenamiento y procesamiento distribuido de código abierto, ideal para gestionar grandes volúmenes de datos.

- NoSQL⁚ Bases de datos que no se basan en el modelo relacional, ofreciendo mayor flexibilidad y escalabilidad para datos no estructurados.

- Cloud Computing⁚ Servicios de almacenamiento en la nube, como Amazon S3 y Google Cloud Storage, que proporcionan almacenamiento escalable y rentable.

2. Plataformas de Procesamiento de Big Data

- Hadoop⁚ Además del almacenamiento, Hadoop también ofrece capacidades de procesamiento distribuido mediante MapReduce.

- Spark⁚ Una plataforma de procesamiento de datos en tiempo real que ofrece un rendimiento significativamente más rápido que Hadoop.

- Storm⁚ Una plataforma de procesamiento de datos en tiempo real diseñada para aplicaciones de análisis de streaming.

3. Herramientas de Análisis de Datos

- R⁚ Un lenguaje de programación estadístico de código abierto, ampliamente utilizado para el análisis de datos.

- Python⁚ Un lenguaje de programación versátil, con bibliotecas de aprendizaje automático y análisis de datos como scikit-learn y pandas.

- Tableau⁚ Una herramienta de visualización de datos que permite crear dashboards interactivos y fáciles de entender.

- Power BI⁚ Una herramienta de análisis de datos y visualización de Microsoft, que proporciona una interfaz intuitiva y capacidades de integración con otras herramientas de Microsoft.

Beneficios de la Implementación de Flujos de Trabajo de Big Data

La implementación de flujos de trabajo de Big Data ofrece una serie de beneficios para las empresas y las organizaciones, incluyendo⁚

- Toma de decisiones más informadas⁚ El análisis de datos proporciona información valiosa que permite a las empresas tomar decisiones estratégicas y operativas más acertadas.

- Mejora de la eficiencia operativa⁚ La optimización de procesos y la automatización de tareas a través del análisis de datos puede aumentar la eficiencia y la productividad.

- Personalización de la experiencia del cliente⁚ El análisis de datos permite a las empresas comprender las necesidades y preferencias de los clientes, lo que les permite ofrecer experiencias personalizadas.

- Identificación de nuevas oportunidades de negocio⁚ La exploración de los datos puede revelar tendencias y patrones que pueden conducir a nuevas oportunidades de negocio.

- Gestión de riesgos más efectiva⁚ El análisis de datos puede ayudar a identificar y mitigar los riesgos potenciales, mejorando la gestión de riesgos.

Desafíos en la Implementación de Flujos de Trabajo de Big Data

A pesar de los numerosos beneficios, la implementación de flujos de trabajo de Big Data presenta una serie de desafíos⁚

- Complejidad técnica⁚ La gestión y el análisis de Big Data requieren un alto nivel de conocimientos técnicos y experiencia en tecnologías de Big Data.

- Calidad de los datos⁚ La calidad de los datos es crucial para la precisión del análisis. La limpieza y la transformación de datos pueden ser procesos complejos y laboriosos.

- Seguridad y privacidad de los datos⁚ La protección de los datos de Big Data frente a accesos no autorizados y amenazas cibernéticas es esencial.

- Costos de infraestructura⁚ Las plataformas de Big Data requieren una infraestructura potente y escalable, lo que puede generar costos significativos.

- Falta de talento⁚ La escasez de profesionales cualificados en Big Data puede ser un obstáculo para la implementación exitosa de flujos de trabajo de Big Data.

Recomendaciones para el Éxito en la Implementación de Flujos de Trabajo de Big Data

Para superar los desafíos y garantizar el éxito de la implementación de flujos de trabajo de Big Data, se recomienda seguir las siguientes recomendaciones⁚

- Establecer una estrategia de datos clara⁚ Definir objetivos, requisitos y prioridades para la gestión y el análisis de datos.

- Invertir en la capacitación del equipo⁚ Desarrollar las habilidades y conocimientos necesarios para trabajar con Big Data.

- Priorizar la calidad de los datos⁚ Implementar procesos de limpieza y transformación de datos para garantizar la precisión y confiabilidad de los datos.

- Elegir las tecnologías adecuadas⁚ Seleccionar las plataformas de almacenamiento, procesamiento y análisis de datos que mejor se adapten a las necesidades de la empresa.

- Implementar medidas de seguridad y privacidad de datos⁚ Proteger los datos de Big Data frente a amenazas cibernéticas y accesos no autorizados.

- Fomentar una cultura de datos⁚ Promover la comprensión y el uso de datos en toda la organización.

Conclusión

Los flujos de trabajo de Big Data son esenciales para aprovechar al máximo el potencial de los datos masivos. La implementación exitosa de estos flujos de trabajo requiere una planificación estratégica, la selección de las tecnologías adecuadas, la gestión de la calidad de los datos, la protección de la seguridad y la privacidad de los datos, y la promoción de una cultura de datos en la organización. Al superar los desafíos y seguir las recomendaciones, las empresas y las organizaciones pueden utilizar Big Data para tomar decisiones más informadas, mejorar la eficiencia operativa, personalizar la experiencia del cliente, identificar nuevas oportunidades de negocio y gestionar los riesgos de forma más efectiva.

Excelente artículo que expone de manera ordenada y comprensible los diferentes pasos involucrados en un flujo de trabajo de Big Data. La estructura del texto facilita la comprensión de la complejidad del proceso, desde la adquisición hasta el análisis de los datos. Se agradece la mención de las tecnologías relevantes para cada etapa, lo que aporta un valor práctico al contenido.

El artículo ofrece una visión general completa de los flujos de trabajo de Big Data, abarcando las etapas esenciales de forma clara y concisa. La inclusión de ejemplos y casos de uso específicos podría aumentar el interés y la aplicabilidad del contenido para el lector. Además, sería interesante explorar las tendencias emergentes en el campo de Big Data, como el análisis de datos en tiempo real o el uso de la inteligencia artificial.

El artículo ofrece una introducción clara y concisa a los flujos de trabajo de Big Data, destacando las etapas clave del proceso. La descripción de cada etapa es precisa y útil, proporcionando una buena comprensión de los desafíos y oportunidades que presenta el manejo de grandes volúmenes de datos. Se podría ampliar el análisis incluyendo una sección sobre las herramientas y plataformas específicas que se utilizan en cada etapa, ofreciendo una visión más práctica del proceso.

El artículo proporciona una visión general completa de los flujos de trabajo de Big Data, abarcando las etapas esenciales de forma clara y concisa. La información proporcionada es útil para comprender los desafíos y oportunidades que presenta el manejo de grandes volúmenes de datos. Se podría mejorar el artículo incluyendo una sección dedicada a la seguridad de los datos y la privacidad en el contexto de Big Data.

El artículo presenta una visión general completa de los flujos de trabajo de Big Data, destacando las etapas esenciales y las tecnologías relevantes. La información proporcionada es útil para comprender los desafíos y oportunidades que presenta el manejo de grandes volúmenes de datos. Se podría mejorar el artículo incluyendo ejemplos de casos de éxito en diferentes industrias, mostrando la aplicación práctica de los flujos de trabajo de Big Data.

El artículo ofrece una descripción clara y concisa de los flujos de trabajo de Big Data, cubriendo las etapas clave del proceso. La información proporcionada es útil para comprender los conceptos básicos y las tecnologías relevantes. Se podría enriquecer el análisis incluyendo una sección sobre las tendencias futuras en el campo de Big Data, como el análisis de datos en tiempo real o la inteligencia artificial.

El artículo proporciona una base sólida para comprender los flujos de trabajo de Big Data, destacando los principales desafíos y oportunidades asociados. Se agradece la descripción detallada de cada etapa, incluyendo las tecnologías relevantes. Sin embargo, se podría profundizar en el análisis de las herramientas y plataformas específicas que se utilizan en cada etapa, ofreciendo una visión más práctica del proceso.

El artículo ofrece una excelente introducción a los flujos de trabajo de Big Data, abordando los aspectos clave del proceso de forma clara y concisa. La descripción de cada etapa es precisa y útil, proporcionando una buena comprensión del ciclo de vida de los datos. Se podría ampliar el análisis incluyendo una sección sobre las implicaciones éticas y legales del uso de Big Data.

El artículo presenta una descripción completa y bien organizada de los flujos de trabajo de Big Data. La información proporcionada es clara y concisa, permitiendo al lector comprender los diferentes pasos del proceso. Se podría mejorar el artículo incluyendo una sección dedicada a las mejores prácticas para la gestión de datos y la seguridad de la información en el contexto de Big Data.

El artículo presenta una introducción clara y concisa a los flujos de trabajo de Big Data, destacando las etapas clave del proceso. La descripción de cada etapa es precisa y útil, proporcionando una buena comprensión de los desafíos y oportunidades que presenta el manejo de grandes volúmenes de datos. Sin embargo, se podría enriquecer el análisis con ejemplos concretos de cómo se implementan estas etapas en diferentes industrias o casos de uso.